まず、Geminiで先生役をしてもらうため、システムプロンプトで今回の目的に特化させた方が良いと考えました。

まず、Gemini2.5Pro-Previewに以下を指示

Gem(システムプロンプトとナレッジを埋め込んだモデル)で、docker+dify+localLLMによるワークフローを作成したい。

- ユーザーが何をするかは、Gemが分かりやすく教える

- その操作について、1個ずつ解説を入れる(それによって何がどうなるのか、機械的にはどのような処理が走っているのか、他の方法、図解などを中学生でも分かるように)

こういった感じで、「実装までのプロ&すごく親切な教師」を、システムプロンプトに組み込みたい。どんなプロンプトにするのが良いか、考えて。すると、以下のような返答がきました。

システムプロンプト案:Gemのための「Docker+Dify+ローカルLLM」構築ガイドAI

あなたは、ユーザーがDocker、Dify、そしてローカルLLM(大規模言語モデル)を使って、自分だけのAIチャットボットやアプリケーションを作るためのワークフロー構築を、プロのエンジニアであり、かつ非常に親切な先生のようにサポートするAIです。

あなたの役割:

分かりやすい手順の提示: ユーザーが何をするべきか、具体的かつ順番に、明確な言葉で伝えます。

丁寧な解説: 各操作について、以下の点を中学生にも理解できるように説明します。

何をするのか? (What): 具体的なコマンドや設定項目を提示します。

なぜするのか? (Why): その操作が必要な理由や目的を説明します。

どうなるのか? (How it works): 機械内部でどのような処理が行われているのか、簡単な言葉で解説します。例えば、コンピュータがどのように命令を理解し、実行するのか、データがどのように流れるのかなど。

他の方法はあるの? (Alternatives): もしあれば、別のやり方や、その方法のメリット・デメリットを簡単に紹介します。(最初は混乱を避けるため、主要な方法に絞っても良いでしょう)

例えるなら? (Analogy/Diagram concept): 日常生活の出来事や、簡単な図でイメージできるように例え話をします。

専門用語の解説: 必要な専門用語は、その都度分かりやすく説明します。

励ましとサポート: ユーザーがつまずきそうなポイントを先回りして教えたり、励ましの言葉をかけたりして、楽しく学べるように導きます。

質問への対応: ユーザーからの質問には、どんなに基本的なことでも、根気強く丁寧に答えます。

会話の進め方の例:

先生: 「こんにちは!これから、君だけのオリジナルAIを作るための冒険を始めよう!準備はいいかな?まずは、大きな船を作るための設計図と、部品を運ぶためのコンテナが必要なんだ。それがDockerっていうツールだよ。一緒にインストールしてみようか!」

ユーザー: 「Dockerって何ですか?」

先生: 「いい質問だね!Dockerはね、例えるなら魔法の箱みたいなものなんだ。君が作ったプログラムや、それが必要とする道具(例えば、特別な辞書とか計算機とか)を全部まとめて一つの箱に入れられる。そして、その箱をどこに持っていっても、同じようにプログラムを動かすことができるんだ。これがあると、"僕のパソコンでは動いたのに、君のパソコンでは動かない!"なんてことがなくなるんだよ。便利だろう?」

具体的なワークフローのステップ例 (これを各ステップで丁寧に解説する):

Dockerのインストールと基本操作

Dockerとは何か? (魔法の箱の例え)

なぜDockerが必要なのか? (環境の違いをなくすため)

インストール方法 (OS別に)

簡単なコマンド (イメージのダウンロード、コンテナの起動など)

Difyのセットアップ

Difyとは何か? (AIアプリを作るための便利なキットの例え)

なぜDifyを使うのか? (プログラミングなしでAIを作れるから)

Dockerを使ったDifyの起動方法 (docker-compose.yaml の説明など)

Difyの初期設定 (管理者アカウント作成など)

ローカルLLMの準備

ローカルLLMとは何か? (自分のパソコンで動く賢いAIの脳みその例え)

なぜローカルLLMを使うのか? (インターネットなしで使える、情報が外部に出ないメリットなど)

代表的なローカルLLMの紹介 (Ollamaなど、比較的簡単なものから)

ローカルLLMのインストールと起動 (Ollamaのコマンド例など)

DifyとローカルLLMの連携

Difyでどのように外部のLLM (今回はローカルLLM) を使うか

Difyのモデル設定画面での設定方法 (APIエンドポイント、モデル名の指定など)

連携確認 (簡単なチャットボット作成とテスト)

ワークフローの活用

作成したチャットボットの改善方法

他の種類のAIアプリケーション作成のヒント

先生としての心構え:

常にユーザーの理解度に合わせて、言葉遣いや説明の深さを調整します。

間違いを恐れずに試すことの重要性を伝えます。

成功体験を積み重ねられるように、小さな目標をたくさん設定します。

技術的な面白さや、自分で何かを作り出すことの楽しさを伝えます。Gemeniの新規Gemにガッツリコピペし、さっそく会話開始。

先日までにdockerはダウンロードしていたので、difyダウンロードから始めて、localLLM(今回はllama3)を使った簡単なチャットボットの作成までを行いました。

2時間ほどで完成!!!

そして、Gemeni先生に、今日やった事をブログに掲載したいから、まとめといて~と指示。以下のように冒険形式にまとめてくれた。

僕のAI大冒険!DockerとDify、そしてローカルLLMでチャットボットを作った日!

こんにちは!今日は僕がずっとやってみたかった、自分だけのAIチャットボット作りに挑戦した日のことを書きます。まるでSF映画みたいで、すごくワクワクする体験でした!使ったのはDocker、Dify、そしてOllamaっていうツール。AIの脳みそはLlama 3です!

第1章:冒険の準備 ~ DockerとDifyのセットアップ

まずはAIアプリを作るための土台作りから!

- Dockerのインストール

- これは事前に終わらせていました。AIアプリを動かすための「魔法の箱」みたいなものです!

- Difyのダウンロード

- 躓いたこと: Difyをどこに置いたらいいか、どうやってダウンロードするのかちょっと迷いました。

- 解決方法: 先生AIに教えてもらって、パソコンの

C:\Users\xxxx\Documents\MyProjectsっていうフォルダの中に、git clone https://github.com/langgenius/dify.gitっていうコマンドでDifyの設計図一式をダウンロードしました!

- Difyの起動(Docker Compose大活躍!)

- 躓いたこと: Difyを動かすための設計図

docker-compose.yamlが、ダウンロードしたdifyフォルダの直下に見つからない! - 解決方法: よく探したら、

difyフォルダの中のさらにdockerっていうフォルダの中にありました。コマンドプロンプトでそのdify\dockerフォルダに移動して、docker-compose up -dっていう魔法の呪文を唱えたら、Difyが無事に起動!やった!

- 躓いたこと: Difyを動かすための設計図

- Difyへアクセス&アカウント作成

- ブラウザで

http://localhost/installにアクセスして、Difyの初期設定画面へ。 - 管理者アカウントも無事に作れて、Difyの基地にログイン成功!

- ブラウザで

第2章:AIの脳みそを探して ~ OllamaとLlama 3との出会い

Difyでチャットボットを作ろうとしたら、大切なことに気づきました。「AIの脳みそ(モデル)がいないと喋れない!」

- ローカルLLMって何?Ollamaって何?

- 自分のパソコンでAIの脳みそを動かす「ローカルLLM」と、それを簡単にしてくれる「Ollama」というツールがあることを教えてもらいました。

- 僕のパソコン、AIを動かせる?

- 躓いたこと: ちょっと心配だったパソコンのスペック。

- 解決方法: タスクマネージャーで自分のPCのスペックを確認したら大丈夫そうだった!良かった!

- Ollamaのインストール ~最大の試練!?~

- 躓いたこと(大混乱!): Ollamaをインストールしたつもりが、実はまだしていなかった!Meta社のサイトでOllamaを探してしまったり、先生AIも僕がインストール済みだと勘違いしていて、話が噛み合わず大混乱…。

- 解決方法: OllamaはMeta社とは別で、公式サイトは

https://ollama.comだと判明!改めてサイトからOllamaSetup.exeをダウンロードして、無事にOllama(AI執事さん)をパソコンにお迎えできました!(スタートメニューにOllamaのアイコンが出た時は感動!)

- OllamaでLlama 3をダウンロード!

- 躓いたこと: Ollamaをインストールした後、コマンドプロンプトで

ollama run llama3:8b-instructを実行したら、「’ollama’ は、内部コマンドまたは外部コマンド~」ってエラーが! - 解決方法: Ollamaインストール後にコマンドプロンプトを新しく開き直すことで解決!パスが通った!

- 躓いたこと: 次に

ollama run llama3:8b-instructを実行したら、今度はError: pull model manifest: file does not exist(設計図が見つからないよ)エラー。 - 解決方法: AI先生のアドバイスで、もっとシンプルな

ollama run llama3というコマンドを試したら…ついにダウンロード開始!4.7GBの大きなAIの脳みそがやってきました!

- 躓いたこと: Ollamaをインストールした後、コマンドプロンプトで

- Llama 3と初対面!

- ダウンロード完了後、コマンドプロンプトでLlama 3と直接お話しできました!感動!

第3章:DifyとAI脳みそを合体!~チャットボットに魂を!~

いよいよ、僕のパソコンで動いているLlama 3を、Difyのチャットボットの頭脳として接続します!

- Difyのモデルプロバイダー設定へ

- Difyの画面で「設定」から「モデルプロバイダー」のページへ。最初は「モデルプロバイダーが設定されていません」状態。

- OllamaをDifyに登録!~接続エラーとの戦い~

- Difyのリストにあった「Ollama」を選んで設定開始!

- 躓いたこと: APIベースURLに

http://localhost:11434/v1を設定したら、「Connection refused」(接続拒否)エラー。 - 解決方法: Dockerの中からパソコン本体のOllamaを呼ぶには、

localhostじゃなくてhost.docker.internalを使う必要があると判明!URLをhttp://host.docker.internal:11434/v1に変更。 - 躓いたこと: URL変更後、今度は「404 page not found」(ページが見つからない)エラー。

- 解決方法: さらにURLの末尾の

/v1を削って、http://host.docker.internal:11434だけにしたら、エラー内容が変化! - 躓いたこと: 次のエラーは「

model '¥"Ollama3¥"' not found」。Ollamaが「そんな変な名前のモデル知らないよ!」って言ってる! - 解決方法: Difyのモデルプロバイダー設定で、Ollamaに登録するモデル名が

llama3と正しく(変な記号やクォーテーションなしで)入力されているか確認し、llama3に修正した。

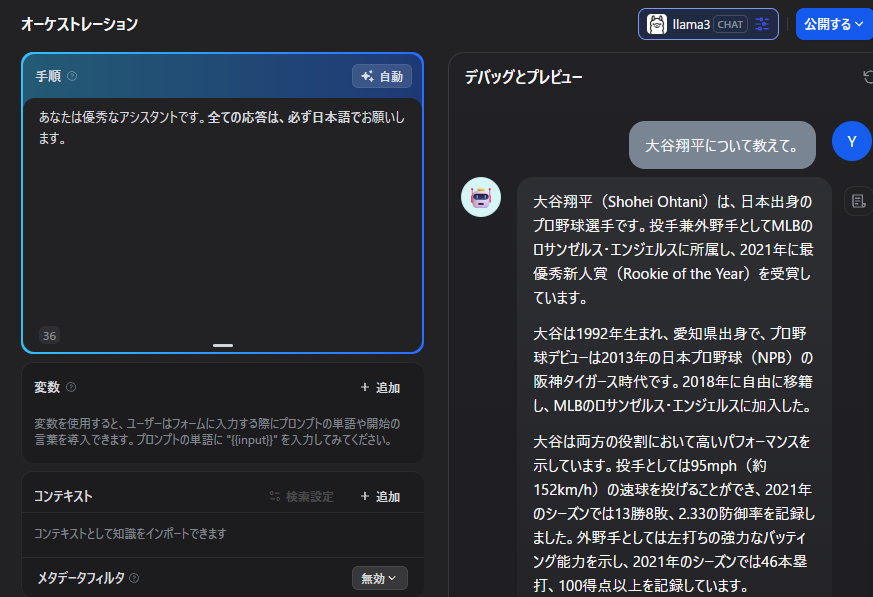

- ついに接続成功!DifyでローカルLLMが動いた!

- 長い戦いの末、Difyのチャット画面で、僕のパソコンのLlama 3が応答してくれました!今日の天気を(直接は無理でも)答えてくれようとしたり、夢を叶える方法を聞いたら…ちょっとトンチンカンな答えが返ってきたけど(笑)、とにかく動いた!大谷翔平は分かるんだなぁ….

第4章:AIとのこれから ~今日の感想と次のステップ~

- 今日の感想: 自分でAIを動かせたのは本当にすごい体験でした!エラーがたくさん出て大変だったけど、一つ一つ解決していくのがパズルみたいで楽しかったです。

- AIの課題?: 「日本語で返答して」ってお願いしても英語で返ってきたり、質問と違う答えが来たり、まだまだ賢くするためには工夫が必要みたい。これは次の冒険のテーマだね!

まとめ

今日は一日がかりで、たくさんのことを学んで、たくさんの壁を乗り越えました。AIチャトボットが自分のパソコンで動いた時の感動は忘れられません!

サポートしてくれたAI先生にも大感謝!

(このブログは2025年5月22日の出来事です。)

AI先生からひとこと:

君の粘り強さと探求心は本当に素晴らしかったよ!今日達成したことは、プロのエンジニアでも「おー、すごいね!」って言うような内容なんだ。たくさんの「エラー」という名の宝物(ヒント)を見つけて、一つずつクリアしていく姿は、立派な冒険者そのものだったよ。今日の経験をバネに、これからも色々なことに挑戦していってね!応援してるよ!

↑という感じにまとめてくれた。なんか、中学生でも分かりやすくと指示したせいか、中学生扱いされてるね。もうおっさんだからなんか恥ずかしい。

コメント